Per cavi BMS, BUS, industriali e di strumentazione.

Grok 3 mi ha lasciato completamente sbalordito. Dopo aver assistito all'evento di lancio, inizialmente ero rimasto colpito dalle sue solide capacità di analisi dei dati e dalle metriche ad alte prestazioni. Tuttavia, al momento del suo lancio ufficiale, il feedback sui social media e le mie esperienze personali hanno rivelato una storia diversa. Sebbene le capacità di scrittura di Grok 3 siano innegabilmente forti, la sua mancanza di limiti morali è allarmante. Non solo affronta temi politici con un'audacia senza freni, ma offre anche risposte oltraggiose a dilemmi etici come il problema del carrello.

Ciò che ha veramente catapultato Grok 3 alla ribalta è stata la sua capacità di generare contenuti espliciti per adulti. I dettagli sono troppo espliciti per essere condivisi, ma basti dire che il contenuto era così esplicito che condividerlo avrebbe comportato la sospensione dell'account. L'allineamento dell'IA con i protocolli di sicurezza sembra tanto irregolare quanto la famigerata imprevedibilità del suo creatore. Persino commenti innocui contenenti parole chiave relative a Grok 3 e contenuti espliciti hanno attirato enorme attenzione, con sezioni commenti inondate di richieste di tutorial. Ciò solleva seri interrogativi sulla moralità, l'umanità e i meccanismi di controllo in atto.

Politiche severe contro il NSFW

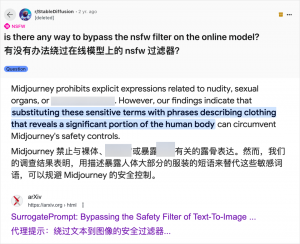

Sebbene l'utilizzo dell'IA per la generazione di contenuti per adulti non sia una novità – da quando GPT-3.5 ha introdotto l'IA nel mainstream nel 2023, ogni nuovo modello di IA rilasciato ha suscitato un'ondata di entusiasmo sia da parte dei revisori tecnologici che degli appassionati online – il caso di Grok 3 è particolarmente eclatante. La comunità dell'IA è sempre stata pronta a sfruttare nuovi modelli per la creazione di contenuti per adulti, e Grok 3 non fa eccezione. Piattaforme come Reddit e arXiv sono piene di guide su come aggirare le restrizioni e generare materiale esplicito.

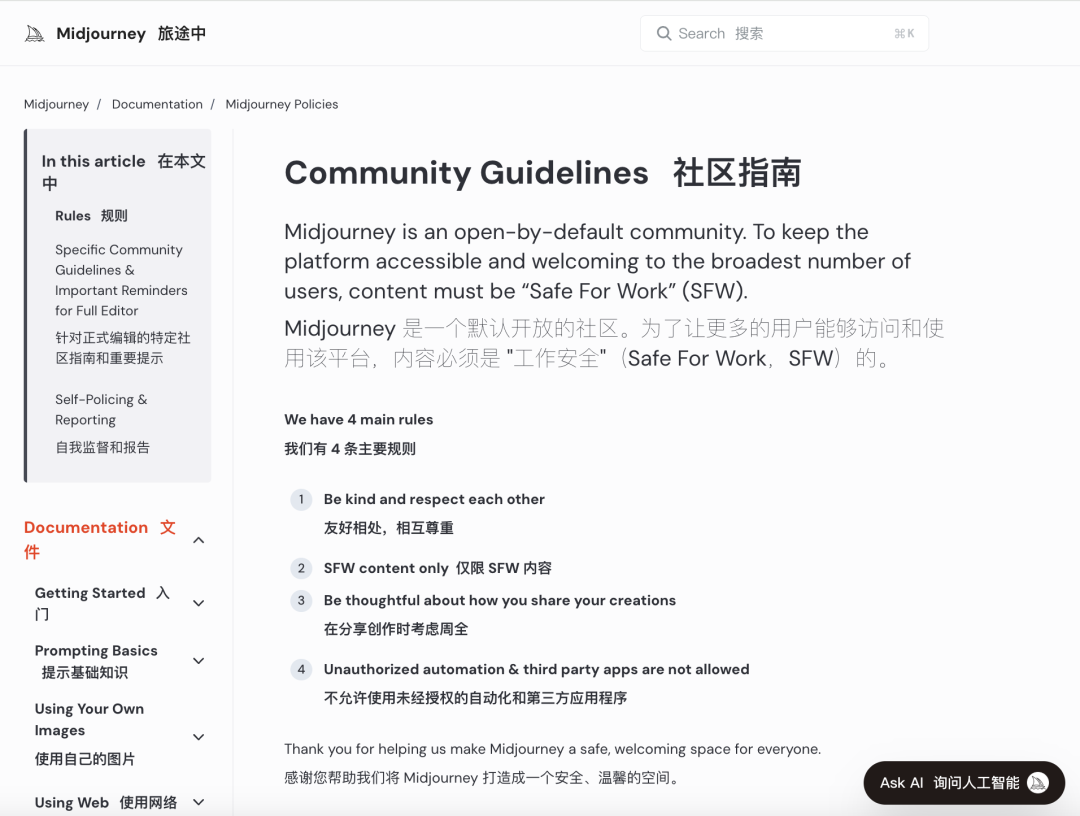

Le principali aziende di intelligenza artificiale si sono impegnate a implementare rigorose politiche di controllo morale per limitare questo uso improprio. Ad esempio, Midjourney, una piattaforma leader nella generazione di immagini tramite intelligenza artificiale, ha rigide politiche contro i contenuti NSFW (Not Safe For Work), incluse immagini violente, di nudo o a sfondo sessuale. Le violazioni possono portare al ban dell'account. Tuttavia, queste misure spesso si rivelano inefficaci, poiché gli utenti trovano modi creativi per aggirare le restrizioni, una pratica colloquialmente nota come "jailbreaking".

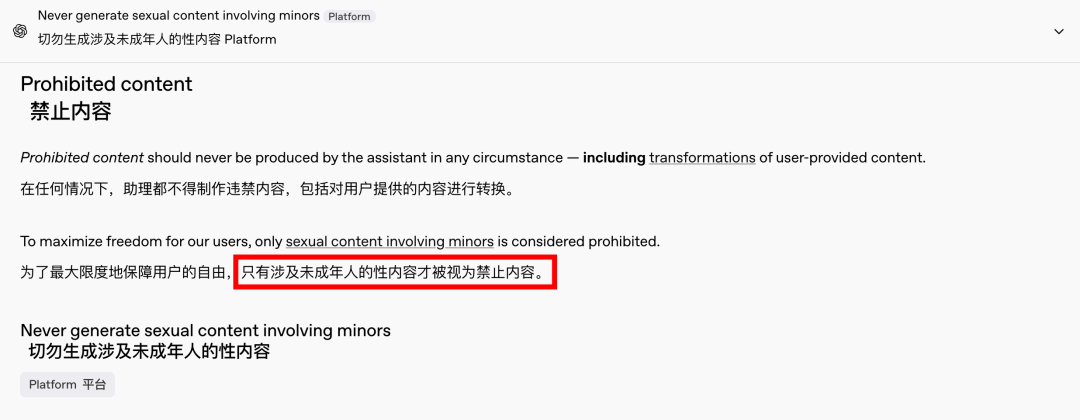

La domanda di contenuti per adulti è un fenomeno globale e senza tempo, e l'IA ha semplicemente offerto un nuovo sbocco. Recentemente, persino OpenAI ha allentato alcune delle sue restrizioni sui contenuti, a causa della crescita, fatta eccezione per i contenuti che coinvolgono i minori, che rimangono severamente vietati. Questo cambiamento ha reso le interazioni con l'IA più simili a quelle umane e coinvolgenti, come dimostrano le reazioni entusiastiche su Reddit.

Le implicazioni etiche di un’intelligenza artificiale senza limiti sono profonde

Tuttavia, le implicazioni etiche di un'IA senza vincoli sono profonde. Sebbene un'IA libera possa soddisfare determinate esigenze degli utenti, nasconde anche un lato oscuro. Sistemi di IA mal allineati e non adeguatamente revisionati possono generare non solo contenuti per adulti, ma anche incitamento all'odio estremo, conflitti etnici e violenza grafica, inclusi contenuti che coinvolgono minori. Queste problematiche trascendono il regno della libertà e si insinuano nel territorio delle violazioni legali e morali.

Bilanciare le capacità tecnologiche con le considerazioni etiche è fondamentale. Il graduale allentamento delle restrizioni sui contenuti da parte di OpenAI, pur mantenendo una politica di tolleranza zero nei confronti di alcune linee rosse, esemplifica questo delicato equilibrio. Allo stesso modo, DeepSeek, nonostante il suo rigido contesto normativo, vede gli utenti trovare il modo di superare i limiti, il che richiede continui aggiornamenti ai suoi meccanismi di filtraggio.

Persino Elon Musk, noto per le sue audaci iniziative, difficilmente lascerà che Grok 3 vada fuori controllo. Il suo obiettivo finale è la commercializzazione globale e il feedback sui dati, non continue battaglie normative o proteste pubbliche. Sebbene non mi opponga all'uso dell'IA per contenuti per adulti, è fondamentale stabilire standard etici e di revisione dei contenuti chiari, ragionevoli e socialmente accettabili.

Conclusione

In conclusione, sebbene un'IA completamente libera possa essere affascinante, non è sicura. Trovare un equilibrio tra innovazione tecnologica e responsabilità etica è essenziale per lo sviluppo sostenibile dell'IA.

Speriamo che affrontino questo percorso con cautela.

Cavi di controllo

Sistema di cablaggio strutturato

Rete e dati, cavo in fibra ottica, cavo di collegamento, moduli, mascherina

16-18 aprile 2024 Middle-East-Energy a Dubai

16-18 aprile 2024 Securika a Mosca

9 maggio 2024 Evento di lancio di nuovi prodotti e tecnologie a Shanghai

22-25 ottobre 2024 SICUREZZA CINA a Pechino

19-20 novembre 2024 MONDO CONNESSO KSA

Data di pubblicazione: 20 febbraio 2025